Der Einsatz von ChatGPT in der Radiologie

Für Sprachmodelle wie ChatGPT gibt es viele denkbare Anwendungsmöglichkeiten in der Radiologie. Allerdings kommt derzeit der Einsatz in der klinischen Routine aus vielerlei Gründen nicht in Frage.

Sprachmodelle, die darauf trainiert sind, menschliche Sprache zu verstehen und auf natürliche Art und Weise darauf zu antworten, gibt es schon seit Längerem. Doch im November 2023 machte das US-Unternehmen OpenAI sein Sprachmodell ChatGPT für die breite Öffentlichkeit zugänglich und sorgt seither für einen ungebrochenen Hype um diese KI-Technologie. Bereits im Januar dieses Jahres konnte ChatGPT 100 Millionen aktive Nutzer verzeichnen – ein gigantischer Zuwachs, der sogar den damaligen Start der Videoplattform TikTok übertraf. Täglich wird über neue Anwendungsmöglichkeiten der Sprachmodelle berichtet, aber auch vor möglichen Risiken und Gefahren gewarnt. Auch im medizinischen Sektor ist das Thema in aller Munde. Davon zeugt die steigende Zahl von Publikationen in einschlägigen Fachzeitschriften.

„Das Potenzial großer Sprachmodelle in der Radiologie ist sehr hoch – sofern diese mit der richtigen Zielsetzung angewendet werden“, erklärt Dr. Matthias A. Fink, Oberarzt an der Klinik für Diagnostische und Interventionelle Radiologie am Universitätsklinikum Heidelberg, der sich im Rahmen seiner Forschung mit Natural Language Processing, also mit Techniken und Methoden zur maschinellen Verarbeitung natürlicher Sprache, beschäftigt. Kaum war ChatGPT online, begann Fink das Sprachmodell zu untersuchen und hat sich einen Überblick darüber verschafft, was ChatGPT im klinischen Kontext kann und was es (noch) nicht kann.

Worin ChatGPT schon jetzt richtig gut ist …

In der Radiologie gibt es zahlreiche mögliche Anwendungsfelder für ChatGPT: Hierzu zählen die Integration klinischer Daten (u. a. Informationen aus der Anamnese, Untersuchungsergebnisse, Laborparameter) für eine effizientere Indikationsstellung in der bildgebenden Diagnostik oder die Erstellung und Strukturierung radiologischer Befunde. Bereits verfasste und im radiologischen Informationssystem hinterlegte Befunde können durch die Modelle prozessiert und relevante Informationen für Klinik und Forschung mit hoher Genauigkeit extrahiert werden, wie Fink und sein Team bereits in ihrer Arbeit in der renommierten Fachzeitschrift Radiology zeigen konnten (1).

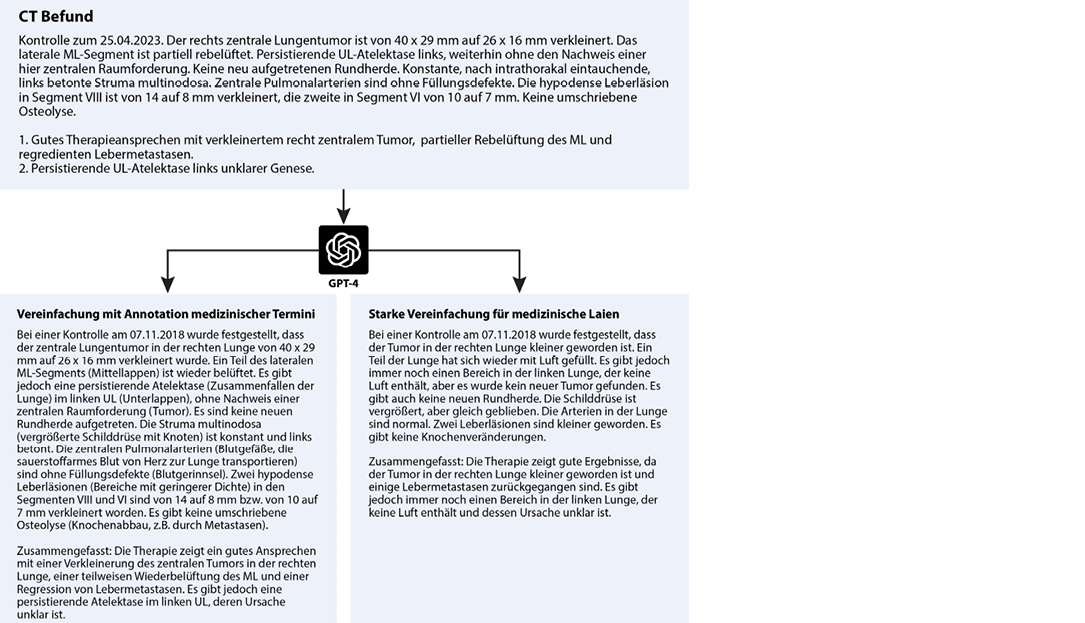

Große Sprachmodelle könnten zudem als hilfreiches Übersetzungstool fungieren, das radiologische Befunde an unterschiedliche Niveaus medizinischer Sprache anpasst, die dem Wissensstand der Patienten Rechnung tragen. „Das kann ChatGPT ausgesprochen gut“, sagt Fink, der die Translation eines onkologischen Befunds in zwei Texte mit unterschiedlichen Bildungsniveaus durch ChatGPT anhand eines Beispiels veranschaulicht (Abbildung): „Für Patienten mit einem grundlegenden medizinischen Verständnis wird hinter jedem lateinischen Wort in Klammern die Bedeutung auf Deutsch vermerkt, für absolute Laien hingegen verwendet das Modell gar keine medizinischen Termini und der Text ist sprachlich sehr einfach gehalten.”

Eine weitere Anwendungsmöglichkeit wäre ein auf großen Sprachmodellen basierender Chatbot, mit dem Patienten interagieren und sich den Befundinhalt in einem Frage-Antwort-Setting erläutern lassen können. Eine flächendeckende Implementierung kommerzieller Produkte wie ChatGPT im Gesundheitswesen ist in Deutschland jedoch mittelfristig noch nicht abzusehen. Aus einem simplen Grund: ChatGPT ist kein zertifiziertes Medizinprodukt und darf in der unmittelbaren Patientenversorgung nicht eingesetzt werden. Doch es gibt eine Reihe weiterer Gründe, warum die Anwendung von ChatGPT im medizinischen Kontext, insbesondere bei Aufgaben, welche die Analyse und Interpretation komplexer medizinischer Sachverhalte wie Diagnostik und Therapiefindung umfassen, derzeit nur mit größter Vorsicht durchgeführt werden sollte.

… und worauf man lieber nicht vertrauen sollte

„Die neuronale Netzwerkarchitektur, auf dem ChatGPT basiert, ist auf Basis einer enormen Datenmenge trainiert worden, hierunter auch nicht validierte medizinische Daten“, betont Fink. Die Firma OpenAI hat für ihr Sprachmodell ChatGPT zwar keine Details über den Umfang der Trainingsdaten bekannt gegeben. Allerdings sei anzunehmen, dass neben seriösen medizinischen Quellen auch z.B. Frage-Antwort-Plattformen inbegriffen waren, auf denen sich Laien über medizinische Sachverhalte austauschen, erklärt der Radiologe. Als reines medizinisches Nachschlagewerk etwa ist ChatGPT daher nicht zu gebrauchen. Das belegt auch eine Studie aus Kanada: Forscher stellten dem Sprachmodell Fragen aus diversen Teilgebieten der Radiologie, von denen allerdings nur 67 Prozent durch ChatGPT faktisch korrekt beantwortet wurden; die von dem Modell hierzu bereitgestellten Quellenangaben waren dabei in 64 Prozent frei erfunden (3).

ChatGPT neigt dazu, zu „halluzinieren“. Dieser Begriff bezieht sich dabei auf die Tendenz der Modelle, überzeugend klingende Antworten sprachlich fehlerfrei zu erzeugen, obwohl deren Inhalt nicht auf Fakten beruht und schlichtweg falsch ist: Wenn das Sprachmodell eine bestimmte Antwort nicht liefern kann, dann will es dies nicht eingestehen, sondern generiert auf Basis der statistischen Muster in den Trainingsdaten und dem Muster des Eingabetextes die Antwort mit der größten Wahrscheinlichkeit. „Diese Überheblichkeit ist ein großes Problem von ChatGPT“, meint Fink, der „halluzinieren“ in diesem Kontext für den falschen Begriff hält und lieber von „konfabulieren“ spricht. Für eine verlässliche Anwendung in der medizinischen Diagnostik oder therapeutischen Entscheidungsfindung müssen solche Modelle frei von jeglicher Konfabulation, also der Ausgabe von frei Erfundenem, sein – oder den Grad ihrer Sicherheit über die bereitgestellte Information im Sinne einer nachvollziehbaren “AI Explainability” angeben, über die der Anwender den Wahrheitsgehalt der Antwort zumindest abschätzen kann.

Datenschutz und rechtlicher Rahmen

Ein weiteres ungelöstes Problem ist der Datenschutz. „Aktuell gibt es keinen Weg, datenschutzkonform mit diesen Modellen zu interagieren“, bekräftigt Fink. Die Server der großen Anbieter generativer Sprachmodelle, hierzu zählt neben OpenAI bspw. auch der Alphabet-Konzern (Google) mit seinen Produkten LaMDA/Bard, stehen überwiegend in den USA, und es ist teilweise noch ungeklärt, wie die Unternehmen mit ihren Modellen die Datenschutzvorgaben der EU einhalten wollen. OpenAI macht in den Nutzungsbedingungen von ChatGPT bereits klar, dass alle eingegebenen Daten zum weiteren Training und zur Qualitätssicherung verwendet werden können. Hochsensible, personenbezogene medizinische Daten haben daher im Eingabefeld von ChatGPT nichts verloren. „Falls mit solchen Sprachmodellen im medizinischen Kontext gearbeitet wird, müssen die Daten streng anonymisiert sein“, unterstreicht Fink, der im Rahmen seiner Forschungsarbeiten ausschließlich mit nicht identifizierbaren Textdaten gearbeitet hat. „Ärzte, die mit ChatGPT experimentieren, müssen zu einem verantwortungsvollen Umgang mit den Patientendaten finden“, appelliert der Radiologe.

„Bevor datenschutzrechtliche und ethische Aspekte nicht geklärt sind, verbietet sich der Einsatz kommerzieller Produkte wie ChatGPT in der medizinischen Praxis“, resümiert Fink. Er würde sich ein DSGVO-konformes europäisches Sprachmodell wünschen – oder besser noch: ein deutsches Sprachmodell, das auf validen medizinischen Daten trainiert wurde und dessen Server in Deutschland stehen oder sogar lokal in das Kliniknetz eingebunden sind. Das Problem sei eine ausreichend große Datengrundlage für das Training standorteigener Sprachmodelle, die jedoch ein Mindestmaß an Digitalisierung an den Kliniken in Form elektronischer Patientenakten, medizinischer Befunde und OP-Berichten voraussetzt. Eine Alternative bestünde in der Verwendung von öffentlich zugänglichen Open Source-Sprachmodellen wie dem kürzlich veröffentlichten LLaMa 2-Modell des Meta-Konzerns, welche auf lokalen Servern installiert und auf klinikinternen Daten weiter trainiert werden könnten. Fink: “Die Entwicklung und das Training großer Sprachmodelle ist bereits Forschungsschwerpunkt einiger universitärer Standorte in Deutschland und es ist nur eine Frage der Zeit, bis entweder eigens entwickelte und auf die jeweilige klinische Infrastruktur zugeschnittene Lösungen implementiert werden oder kommerzielle Systeme von technischen Partnern Anwendung finden, die den hohen Qualitäts- und Datenschutzstandards unseres Gesundheitswesens entsprechen.“

Profil

Dr. med Matthias Fink, B.Sc. hat an der Johann Wolfgang Goethe-Universität Frankfurt a. M. und an der Ernst-Moritz-Arndt-Universität Greifswald Medizin studiert. In Greifswald hat er zudem den Bachelor of Biomedical Science mit Auszeichnung abgeschlossen.

Fink ist Facharzt für Radiologie und seit Juli 2022 Funktionsoberarzt an der Klinik für Diagnostische und Interventionelle Radiologie (DIR), Universitätsklinikum Heidelberg.

Seit Oktober 2021 ist er Mitglied im „Forscher für die Zukunft“ Netzwerk der Deutschen Röntgengesellschaft. Im Juni 2023 hat der Radiologe als „Young Scientist“ an der 72. Nobelpreisträgertagung in Lindau (Physiology/Medicine) teilgenommen.

Referenzen

1. Fink MA, Bischoff A, Fink CA, et al. Potential of ChatGPT and GPT-4 for Data Mining of Free-Text CT Reports on Lung Cancer. Radiology. Radiological Society of North America; 2023;000(1):0–10. doi: 10.1148/radiol.231362.

2. Fink MA. Große Sprachmodelle wie ChatGPT und GPT-4 für eine patientenzentrierte Radiologie. Radiologie. 2023; doi: 10.1007/s00117-023-01187-8.

3. Wagner MW, Ertl-Wagner BB. Accuracy of Information and References Using ChatGPT-3 for Retrieval of Clinical Radiological Information. Can Assoc Radiol J. SAGE Publications Inc; 2023;08465371231171125. doi: 10.1177/08465371231171125.